Accidente aéreo en Brasil. ¿Fallos en el diseño de interacción?

Me he tomado la libertad de traducir el post que el brasileño Frederic Van Amstel ha publicado recientemente. En él analiza las posibles causas del accidente de avión más grave de la historia de Brasil y plantea la hipóteses de que factores relacionados con la usabilidad hayan podido estar implicados.

Procedo:

El accidente de la Tam podría haber sido causado por problemas de usabilidad

Los controles de vuelo podrían haber contruído en el desastre.

Todo el mundo está buscando la causa y los culpables del accidente de la Tam ocurrido ayer, día 17/07/07 en el aeropuerto de Congonhas. El avión –lleno- intentó aterrizar bajo una lluvia fuerte, en una pista inacabada, a alta velocidad y en plena crisis de la aviación. Derrapó y explotó contra un edificio. Más de 200 muertos.

Ahora la opinión pública quiere culpar a alguien para aliviar su rabia. Los periódicos comentan la posibilidad de un fallo ténico en el avión, pero no se cuestiona que posíbles fallos técnicos hayan podido ocurrir. Los periodistas sólo quieren hablar de sospechosos:

- El presidente Lula, por no haber puesto orden en el asunto después del accidente del avión de la Gol del año pasado;

- Los controladores de vuelo, por haber autorizado el aterrizaje en condiciones poco favorables;

- Los medidores del nivel de agua en pista, por haber informado de que la pista estaba “levemente mojada”;

- Los directores de la Tam, que presionan a los pilotos para aterrizar incluso en condiciones desfavorables para evitar la insatisfacción de los clientes;

- Los pilotos, que no estaban capacitados para la operación o podrían haber cometido errores en la evaluación de la situación.

La investigación puede prolongarse 10 meses, eso si no acaba en “tablas”. Mientras que llega el resultado oficial, las opiniones se dividen en dos hipótesis: un error humano o un fallo mecánico

Yo no entiendo nada de aviación, pero cuando leí la noticia tuve el presentimiento de que podrían ser las dos cosas en conjunto: comportamiento de las personas y adaptación de las máquinas inadecuadas para la situación.

En relación al comportamiento de las personas, que los medios ya se están encargando de evaluarlas –o juzgarlas, mejor dicho, quiero mencionar la inadecuada adaptación de las máquinas, en especial, a nivel del interfaz entre pilotos y sistema. Este punto es relevante para el análisis del accidente porque la acción humana está restringida por las posibilidades que el sistema ofrece. Si los pilotos tomaron una decisión que los llevó al accidente, puede ser que no hubiesen otras alternativas disponibles en el sistema para aquella situación, o incluso existiendo, dichas alternativas no eran visibles.

Antes una aclaración: no soy especialista en el asunto. Lo que escribo a continuación lo hago basándome exclusivamente en mi experiencia como diseñador de interacción para la web, en la lectura de algunos artículos de Donald Norman sobre Psicología Cognitiva en cabinas de vuelo y en una breve investigación que hice sobre la documentación del modelo del avión y simuladores.

Si alguien entiende más que yo sobre el tema que por favor me corrija.

Para empezar, vamos a ver lo que la Tam dice sobre el análisis de los accidentes en su guía para la seguridad en vuelos:

E.3.2.1 “En pocos años, sistemas complejos han evolucionado para sistemas automatizados sofisticados, con muchas interacciones e interfaces. Esos sistemas están a su vez ser formados por subsistemas de hardware, firmware, software electrónico, de aviación, de hidráulica, neumática, biomecánica, ergonomía y factores humanos. Existen complicaciones adicionales que tocan otras consideraciones, como como el potencial de supervisión por la dirección y la percepción del riesgo. Un paradigma más completo del riesgo de un sistema debe considerar todas esas complejidades”.

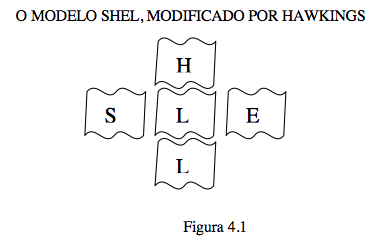

Hasta ahí todo bien. Ellos proponen el modelo SHEL (Software, Hardware, Environment – Ambiente y Liveware – Personas)

A partir de ahí, las personas son tratadas como “Equipamiento humano” y los demás equipamientos deben combinarse con sus características intrínsecas. El problema está en que las personas tienen un hábito pésimo para… “adaptarse a malas combinaciones, ocultando de esa forma, cualquier mala combinación sin eliminarla y, como tal, constituyendo un peligro potencial. Ejemplos de ésto pueden ser los altímetros de tres puntas, el mal layout de los asientos en las cabinas, que puede retrasar una eventual evacuación, etc…”

Yo no diría que eso es un hábito pésimo. Diría que, si una persona es obligada a usar un determinado sistema, lo mejor que puede hacer es adaptarse a él. Y lo inverso también es verdadero: los sistemas se deben adaptar a la persona. En una relación de adaptación mutua, los conflictos se asientan pero, cuando afloran variables externas poco comunes, la adaptación se rompe: el hombre va por un lado y la máquina va por otro. El hombre abandona los procedimientos patrón y se comporta en base a sus emociones, para encontrar una solución inesperada para un problema inesperado, mientras que la máquina solicita o ejecuta procedimientos predefinidos para la solución del problema – eso si identifica el problema como adverso.

Según el relato de los controladores de vuelo de la torre de control del aeropuerto, los pilotos fueron avisados de que la pista estaba mojada y resbalaba antes del aterrizaje. Tocaron el suelo sin problemas, pero sin saber por qué, los pilotos decidieron levantar el vuelo nuevamente. La torre sólo se dio cuenta de que alguna cosa iba mal cuando escucharon a uno de los pilotos gritar “tuerce, tuerce, tuerce”, pero a continuación el avión chocó y explotó. Los colegas de los pilotos creen que el avión entró en acuaplaning (un estado en el que el roce con el suelo se ve reducido), cuando ya no había más espacio, intentaron despegar nuevamente o provocar el derrape.

Es posible que el avión haya entrado demasiado rápido en la pista considerando las condiciones climáticas de la situación, lo que demostraría una decisión errónea por parte de los pilotos. Pero veamos si esa decisión fue tomada sólo por los pilotos o si también la máquina también participó en la toma de decisión.

Según el FCOM (Flight Crew Operating Manual), el manual del A320, cuando la aeronave se encuentra a baja altitud, el modo de control cambia automaticamente. A partir de ese momento, la máquina hace el ajuste automático de la velocidad del avión y del ángulo de inclinación dentro de ciertos límites, que pueden ser redefinidos por el piloto. La imagen siguiente es de un simulador del A320, mostrando la indicación visual de que el “auto-land” está activado:

A continuación, el piloto puede activar el “auto-brake”, que tiene tres opciones:

- Lo – condiciones normales de pista;

- Med – pistas cortas o mojadas;

- Max – no recomendable para aterrizajes.

Puede ser que los pilotos, acostumbrados con el procedimiento patrón, activaran el auto-brake “Lo”, cuando debería ser “Med o Max”. También puede ser que hayan superestimado la velocidad máxima que el avión puede alcanzar en aquella situación y emplearon el procedimiento patrón. En ambos casos, la máquina no toma la decisión sola, pero contribuye a que el piloto la tome.

Cuando se automatizan procedimientos en las máquinas, el proceso no queda explícito para el ser humano. Por esa razón la cabina de un avión tiene tantos displays y controles. Podría estar todo automatizado y controlado a través de pocos controles, pero debido a las experiencias fracasadas en anteriores ocasiones, la aviación intenta reducir al mínimo la automatización.

No obstante, tal vez la aviación no esté atenta a los peligros de la automatización en la acción humana. Cuando las personas repiten los mismos procedimientos varias y varias veces, se tiende a ignorar pequeñas variaciones necesarias, como la reducción de la velocidad en función de la lluvia.

Cuando los pilotos se dieron cuenta de que no era posible parar dentro dela pista ya era demasiado tarde. El procedimiento patrón es identificar la inadecuación para el aterrizaje antes de tocar suelo porque, para levantar nuevamente el vuelo, es necesaria una velocidad mucho más elevada que cuando se aterriza. Si, incluso así, el avión aterriza y sobrepasa una marca que hay en la pista, se le aconseja acelerar. En este caso, el avión aterrizó antes de la marca, pero no consiguión reducir la suficiente velocidad. En realidad el avión aceleró, no se sabe si por intención del piloto o por mal funcionamiento.

Si la investigación apuntase hacia un error humano en la operación, debemos considerar si no serían problemas de usabilidad imprevistos los que surgieron en la situación de riesgo y que no permitieron la rápida recuperación del problema o si la automatización forzó el error humano.

Como comentaba esta mañana con Dani (que también ha publicado la traducción) si las hipótesis que plantea finalmente se confirman, estamos ante un nuevo caso de diseño de interacción mal concebido con consecuencias lamentables.